Isi

- Definisi - Apa yang dimaksud dengan Apache Kudu?

- Pengantar Microsoft Azure dan Microsoft Cloud | Sepanjang panduan ini, Anda akan mempelajari tentang apa itu cloud computing dan bagaimana Microsoft Azure dapat membantu Anda untuk bermigrasi dan menjalankan bisnis Anda dari cloud.

- Techopedia menjelaskan Apache Kudu

Definisi - Apa yang dimaksud dengan Apache Kudu?

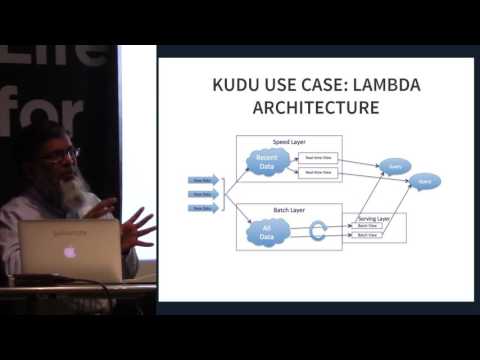

Apache Kudu adalah anggota ekosistem open source Apache Hadoop. Ini adalah mesin penyimpanan sumber terbuka yang ditujukan untuk data terstruktur yang mendukung akses acak latensi rendah bersama dengan pola akses analitik yang efisien. Itu dirancang dan diimplementasikan untuk menjembatani kesenjangan antara Sistem File Terdistribusi Hadoop (HDFS) yang banyak digunakan dan Basis Data HBase NoSQL. Meskipun sistem ini masih terbukti menguntungkan, Apache Kudu dapat memenuhi banyak beban kerja umum karena secara dramatis dapat menyederhanakan arsitekturnya.

Pengantar Microsoft Azure dan Microsoft Cloud | Sepanjang panduan ini, Anda akan mempelajari tentang apa itu cloud computing dan bagaimana Microsoft Azure dapat membantu Anda untuk bermigrasi dan menjalankan bisnis Anda dari cloud.

Techopedia menjelaskan Apache Kudu

Apache Kudu terutama dikembangkan sebagai proyek di Cloudera. Sebagian besar kontribusi hingga saat ini adalah oleh pengembang yang dipekerjakan oleh Cloudera. Selama rilis, hanya binari praktis yang dimasukkan dalam repositori Cloudera, namun ia mengadopsi proses rilis sumber Apache Software Foundation (ASF) setelah bergabung dengan inkubator. Ini secara khusus dirancang untuk kasus penggunaan yang memerlukan analisis cepat pada data cepat. Itu direkayasa untuk mengambil keuntungan dari perangkat keras generasi berikutnya dan pemrosesan dalam memori. Ini menurunkan latensi kueri secara signifikan untuk Apache Impala dan Apache Spark. Ini mendistribusikan data melalui mesin penyimpan kolom atau melalui partisi horisontal, kemudian mereplikasi setiap partisi menggunakan konsensus Raft sehingga memberikan waktu rata-rata rendah untuk pemulihan dan latensi ekor rendah.

Meskipun Kudu adalah produk yang dirancang di dalam ekosistem Apache Hadoop, ia juga mendukung integrasi dengan proyek analisis data lainnya baik di dalam maupun di luar ASF.

Apache Kudu terbukti efisien karena dapat memproses beban kerja analitik waktu-nyata melintasi satu lapisan penyimpanan, sehingga memberikan fleksibilitas kepada para arsitek untuk menangani berbagai kasus penggunaan yang lebih luas tanpa solusi eksotis.