Sumber: Agsandrew / Dreamstime.com

Bawa pulang:

Metode agnostik sumber ideal untuk memproses data untuk analisis Hadoop.

Menyisir sumber data di Hadoop adalah bisnis yang kompleks. Beberapa alasan untuk ini termasuk:

- Skrip khusus sumber khusus yang menggabungkan sumber data bermasalah.

- Menggunakan integrasi data atau alat sains data menimbulkan terlalu banyak ketidakpastian.

- Menambahkan data dari sumber eksternal hampir tidak mungkin.

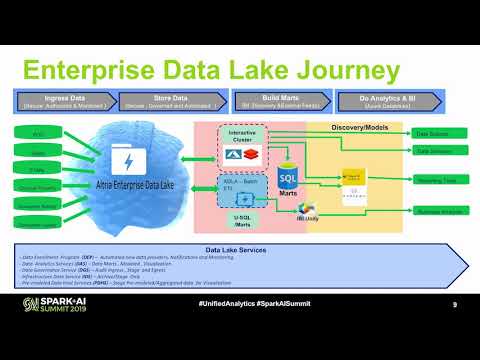

Hari ini, saya akan membahas bagaimana analitik Hadoop ditingkatkan melalui teknologi agnostik sumber yang membuatnya mudah untuk menggabungkan sumber data internal dan eksternal. Selain menjelaskan cara kerja metode agnostik-sumber, saya juga akan membahas mengapa analitik Hadoop membutuhkan kecerdasan bawaan dan kemampuan transfer pengetahuan, pemahaman tentang hubungan dan karakteristik data, dan arsitektur yang dapat diskalakan dan berkinerja tinggi.

- Metode sumber-agnostik termasuk model resolusi entitas yang fleksibel yang memungkinkan sumber data baru ditambahkan menggunakan proses sains data yang dapat diulang secara statistik. Proses-proses ini memanfaatkan algoritma untuk mengumpulkan pengetahuan dari data, dan menilai, menganalisisnya untuk menentukan pendekatan integrasi terbaik.

Tidak peduli seberapa terfragmentasi atau tidak lengkapnya catatan sumber asli, teknologi analitik Hadoop harus menjadi sumber agnostik dan dapat menyatukan data tanpa mengubah atau memanipulasi data sumber. Teknologi ini juga harus membuat indeks entitas berdasarkan konten data, dan atribut tentang individu dan bagaimana mereka ada di dunia. Untuk mencapai hal ini, mereka harus memahami konten data, con, struktur dan bagaimana komponen saling berhubungan. - Built-in data science dan keahlian integrasi data memungkinkan data dibersihkan, distandarisasi dan dikorelasikan dengan tingkat akurasi dan presisi yang tinggi. Alat dan laporan visualisasi membantu analis mengevaluasi dan belajar dari data, dan melakukan penyempurnaan sistem berdasarkan pengetahuan yang diperoleh dari berbagai langkah dalam proses.

- Memahami hubungan antar entitas menghasilkan proses resolusi entitas yang lebih akurat. Karena entitas dunia nyata tidak hanya jumlah atribut mereka, tetapi juga koneksi mereka, pengetahuan hubungan harus digunakan untuk mendeteksi ketika catatan adalah sama. Ini sangat penting untuk menangani kasus sudut dan data besar.

- Karakterisasi data meningkatkan analisis, resolusi, dan penghubungan data dengan mengidentifikasi dan menyediakan informasi untuk sumber-sumber data. Ini dapat membantu untuk memvalidasi konten, kepadatan, dan distribusi data dalam kolom informasi terstruktur. Karakterisasi data juga dapat digunakan untuk mengidentifikasi dan mengekstrak data penting yang terkait dengan entitas (nama, alamat, tanggal lahir, dll.) Dari sumber yang tidak terstruktur dan semi terstruktur untuk berkorelasi dengan sumber terstruktur.

- Arsitektur paralel yang dapat diskalakan melakukan analisis dengan cepat bahkan ketika mendukung ratusan sumber data terstruktur, semi-terstruktur dan tidak terstruktur, dan puluhan miliar catatan.

Hadoop mengubah cara dunia melakukan analitik. Ketika analitik sumber-agnostik baru ditambahkan ke ekosistem Hadoop, organisasi dapat menghubungkan titik-titik di banyak sumber data internal dan eksternal dan mendapatkan wawasan yang sebelumnya tidak mungkin dilakukan.

Artikel ini awalnya diposting di Novetta.com. Telah buluh di sini dengan izin. Novetta mempertahankan semua hak cipta.