Isi

- Big Data Tidak Terstruktur atau Semi-Terstruktur

- Tidak Ada Poin dalam Menyimpan Data Besar Jika Kita Tidak Dapat Memprosesnya

- Bagaimana Hadoop Memecahkan Masalah Big Data

- Kasus Bisnis untuk Hadoop

Bawa pulang:

Hadoop dapat membantu memecahkan beberapa data besar tantangan besar.

Data besar adalah ... baik ... ukurannya besar! Berapa banyak data yang dapat digolongkan sebagai data besar tidak dipotong dengan sangat jelas, jadi jangan terjebak dalam perdebatan itu. Untuk perusahaan kecil yang terbiasa menangani data dalam gigabyte, data 10 TB akan menjadi BESAR. Namun untuk perusahaan seperti dan Yahoo, petabyte besar.Hanya ukuran data besar, membuatnya tidak mungkin (atau setidaknya biaya mahal) untuk menyimpannya di penyimpanan tradisional seperti database atau filers konvensional. Kita berbicara tentang biaya untuk menyimpan gigabytes data. Menggunakan filer penyimpanan tradisional dapat menghabiskan banyak uang untuk menyimpan data besar.

Di sini kita lihat data besar, tantangannya, dan bagaimana Hadoop dapat membantu menyelesaikannya.Pertama, data besar merupakan tantangan terbesar.

Big Data Tidak Terstruktur atau Semi-Terstruktur

Banyak data besar tidak terstruktur. Misalnya, klik stream data log mungkin terlihat seperti:cap waktu, user_id, halaman, referrer_page

Kurangnya struktur membuat database relasional tidak cocok untuk menyimpan data besar. Plus, tidak banyak basis data yang dapat mengatasi penyimpanan miliaran baris data.

Tidak Ada Poin dalam Menyimpan Data Besar Jika Kita Tidak Dapat Memprosesnya

Menyimpan data besar adalah bagian dari permainan. Kita harus memprosesnya untuk menggali informasi intelijen darinya. Sistem penyimpanan tradisional cukup "bodoh" dalam arti bahwa mereka hanya menyimpan bit. Mereka tidak menawarkan kekuatan pemrosesan.Model pemrosesan data tradisional memiliki data yang disimpan dalam cluster penyimpanan, yang disalin ke cluster komputasi untuk diproses. Hasilnya ditulis kembali ke cluster penyimpanan.

Model ini, bagaimanapun, tidak cukup bekerja untuk data besar karena menyalin begitu banyak data ke cluster komputasi mungkin terlalu memakan waktu atau tidak mungkin. Jadi apa jawabannya?

Salah satu solusinya adalah mengolah data besar di tempat, seperti dalam cluster penyimpanan yang berfungsi sebagai cluster komputasi.

Jadi seperti yang telah kita lihat di atas, big data menentang penyimpanan tradisional. Jadi bagaimana kita menangani data besar?

Bagaimana Hadoop Memecahkan Masalah Big Data

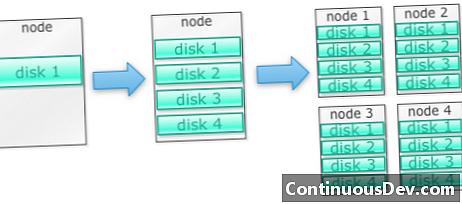

Hadoop dibangun untuk dijalankan pada sekelompok mesinMari kita mulai dengan sebuah contoh. Katakanlah kita perlu menyimpan banyak foto. Kami akan mulai dengan satu disk. Ketika kami melebihi satu disk, kami dapat menggunakan beberapa disk yang ditumpuk pada mesin. Ketika kita maks semua disk pada satu mesin, kita perlu mendapatkan banyak mesin, masing-masing dengan banyak disk.

Inilah tepatnya bagaimana Hadoop dibangun. Hadoop dirancang untuk berjalan pada sekelompok mesin dari awal.

Skala cluster Hadoop secara horizontal

Lebih banyak penyimpanan dan daya komputasi dapat dicapai dengan menambahkan lebih banyak node ke cluster Hadoop. Ini menghilangkan kebutuhan untuk membeli lebih banyak perangkat keras yang lebih kuat dan mahal.

Hadoop dapat menangani data tidak terstruktur / semi-terstruktur

Hadoop tidak memberlakukan skema pada data yang disimpannya. Itu dapat menangani data arbitrer dan biner. Jadi Hadoop dapat mencerna data tidak terstruktur dengan mudah.

Cluster Hadoop menyediakan penyimpanan dan komputasi

Kami melihat bagaimana memiliki cluster penyimpanan dan pemrosesan yang terpisah bukan yang paling cocok untuk data besar. Cluster Hadoop, bagaimanapun, menyediakan penyimpanan dan komputasi terdistribusi secara keseluruhan.

Kasus Bisnis untuk Hadoop

Hadoop menyediakan penyimpanan untuk data besar dengan biaya yang masuk akal

Menyimpan data besar menggunakan penyimpanan tradisional bisa mahal. Hadoop dibangun di sekitar perangkat keras komoditas, sehingga dapat menyediakan penyimpanan yang cukup besar dengan biaya yang masuk akal. Hadoop telah digunakan di lapangan pada skala petabyte.

Satu studi oleh Cloudera menyarankan bahwa perusahaan biasanya menghabiskan sekitar $ 25.000 hingga $ 50.000 per terabyte per tahun. Dengan Hadoop, biaya ini turun menjadi beberapa ribu dolar per terabyte per tahun. Karena perangkat keras menjadi lebih murah dan lebih murah, biaya ini terus turun.

Hadoop memungkinkan untuk menangkap data baru atau lebih

Terkadang organisasi tidak menangkap jenis data karena terlalu mahal untuk menyimpannya. Karena Hadoop menyediakan penyimpanan dengan biaya yang wajar, tipe data ini dapat ditangkap dan disimpan.

Salah satu contohnya adalah log klik situs web. Karena volume log ini bisa sangat tinggi, tidak banyak organisasi yang menangkapnya. Sekarang dengan Hadoop dimungkinkan untuk mengambil dan menyimpan log.

Dengan Hadoop, Anda dapat menyimpan data lebih lama

Untuk mengelola volume data yang disimpan, perusahaan secara berkala membersihkan data yang lebih lama. Misalnya, hanya log selama tiga bulan terakhir yang dapat disimpan, sementara log lama dihapus. Dengan Hadoop dimungkinkan untuk menyimpan data historis lebih lama. Ini memungkinkan analitik baru dilakukan pada data historis yang lebih lama.

Misalnya, ambil log klik dari situs web. Beberapa tahun yang lalu, log-log ini disimpan dalam waktu singkat untuk menghitung statistik seperti halaman-halaman populer. Sekarang dengan Hadoop, layak untuk menyimpan log klik ini untuk jangka waktu yang lebih lama.

Hadoop menyediakan analitik yang skalabel

Tidak ada gunanya menyimpan semua data ini jika kita tidak bisa menganalisisnya. Hadoop tidak hanya menyediakan penyimpanan terdistribusi, tetapi juga pemrosesan terdistribusi juga, yang berarti kita dapat mengolah data dalam jumlah besar secara paralel. Kerangka kerja komputasi Hadoop disebut MapReduce. MapReduce telah terbukti dengan skala petabyte.

Hadoop menyediakan analitik yang kaya

Native MapReduce mendukung Java sebagai bahasa pemrograman utama. Bahasa lain seperti Ruby, Python dan R dapat digunakan juga.

Tentu saja, menulis kode MapReduce khusus bukan satu-satunya cara untuk menganalisis data di Hadoop. Pengurangan Peta tingkat tinggi tersedia. Sebagai contoh, alat bernama Pig mengambil bahasa Inggris seperti data flow language dan menerjemahkannya ke MapReduce. Alat lain, Hive, mengambil kueri SQL dan menjalankannya menggunakan MapReduce.

Alat intelijen bisnis (BI) dapat memberikan tingkat analisis yang lebih tinggi. Ada alat untuk jenis analisis ini juga.

Konten ini dikutip dari "Hadoop Illuminated" oleh Mark Kerzner dan Sujee Maniyam. Ini telah tersedia melalui Creative Commons Attribution-NonCommercial-ShareAlike 3.0 Lisensi Tidak Berportasi.